Après avoir lu des rapports sur les tendances des données, des notes d'analystes et des prédictions industrielles pour 2026, un schéma a continué d'émerger. La conversation est toujours centrée sur l'AI / ML / GenAI. Mais pas de la même manière qu'il y a un ou deux ans. L'accent est passé de l'expérimentation à l'exécution, de la preuve de concept à la preuve de valeur.

Pour de nombreuses organisations, l'avantage concurrentiel en 2026 ne viendra pas du déploiement de plus de modèles AI, mais de l'exploitation de systèmes AI fiables, explicables et soutenus par des fondations de données fiables.

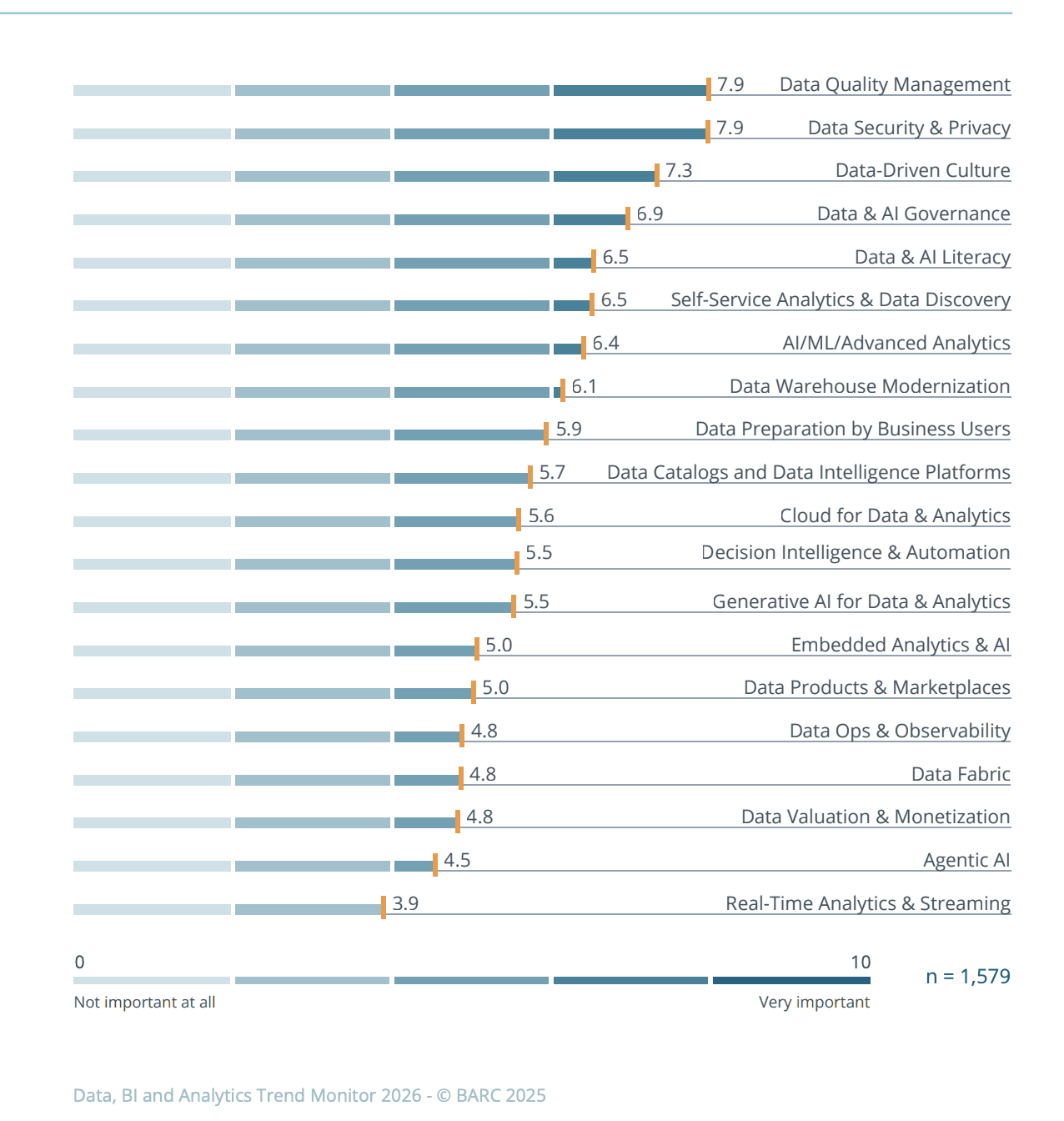

Selon le BARC's Data, BI, and Analytics Trend Monitor 2026, la gestion de la qualité des données a retrouvé sa priorité absolue pour les organisations du monde entier, dépassant les initiatives AI. Même si l'intérêt pour la génération et l'AI agentique croît, les entreprises leaders continueront à se démarquer en équilibrant des fondations solides et l'innovation.

Cet équilibre devient encore plus critique à mesure que les systèmes AI deviennent plus autonomes. Les modèles agentiques et les flux de travail pilotés par AI augmentent à la fois la vitesse et l'impact des décisions, laissant peu de place aux entrées peu fiables. Dans les principales tendances des données de Coalesce pour 2026, un sujet revient souvent : les modèles agentiques relèvent considérablement la barre pour la gestion de la qualité des données. Lorsque les systèmes sont dignes de confiance pour agir et décider seuls, les données derrière ces décisions doivent répondre à une norme plus élevée que jamais.

Le message est simple : l'innovation repose sur des fondations solides, et ces fondations doivent encore être renforcées. Les systèmes en silos, l'utilisation de données non documentées, et le manque de métadonnées rendent difficile l'évaluation de l'adéquation des données pour les cas d'utilisation pilotés par AI, sans parler de les faire évoluer en toute sécurité. En conséquence, les organisations sont forcées de repenser comment les données sont collectées, gérées et validées dans le cadre de leur stratégie AI.

Les tendances qui suivent reflètent comment les organisations leaders répondent à cette réalité en investissant dans des fondamentaux qui permettent à l'AI de fonctionner de manière fiable, responsable et à grande échelle.

Tendance 1 - Les Données Prêtes pour l'AI Deviennent une Priorité de Leadership

En 2026, les CDO seront tenus plus responsables de justifier les dépenses AI, d'expliquer pourquoi les projets pilotes n'atteignent pas l'échelle, et de démontrer l'impact commercial tangible.

Les données prêtes pour l'AI vont au-delà des métriques de qualité traditionnelles comme l'exactitude et la complétude ; elles incluent le contexte, la lignée, la gouvernance, et l'aptitude aux cas d'utilisation autonomes et génératifs de l'AI. Les hallucinations, les prédictions biaisées et les recommandations incohérentes ne proviennent généralement pas des algorithmes eux-mêmes. Elles sont généralement des symptômes de données bruyantes, incomplètes ou mal gouvernées.

Sans des normes de données mesurables en place, les organisations risquent de faire évoluer des systèmes AI difficiles à faire confiance, gouverner ou défendre au niveau exécutif. Et lorsque les résultats AI sont peu fiables, le risque va au-delà de l'investissement perdu. L'intégrité des décisions souffre, l'exposition réglementaire augmente, et la confiance du leadership dans les initiatives basées sur les données diminue.

En conséquence, les organisations commencent à traiter les métriques de qualité des données comme des indicateurs principaux de ROI de l'AI. En pratique, moins d'initiatives AI seront approuvées à moins qu'il y ait des preuves claires que les données sous-jacentes les soutiennent.

À mesure que les organisations passent de l'expérimentation à la production, l'écart entre les pratiques traditionnelles de qualité des données et ce que les systèmes AI nécessitent réellement est devenu impossible à ignorer. Le succès de l'AI n'est plus déterminé par la sophistication algorithmique, mais par la qualité, la gouvernance, et l'intégrité contextuelle des données qui l'alimentent.

Une fois que les données prêtes pour l'AI deviennent une exigence de leadership, les organisations ont besoin de systèmes opérationnels qui peuvent valider et protéger en continu cette préparation en production.

Tendance 2 - Observabilité Automatisée et Détection d'Anomalies

Écrire des règles à la main, revoir les alertes une par une, et enquêter sur chaque anomalie individuellement ne tiennent tout simplement pas la cadence avec les environnements de données modernes. Cette année, les entreprises qui prennent de l'avance ne sont pas celles qui revendiquent des données parfaites. Ce sont celles qui planifient les échecs, apprennent rapidement des problèmes de production, et créent des systèmes qui identifient les problèmes tôt et de manière transparente.

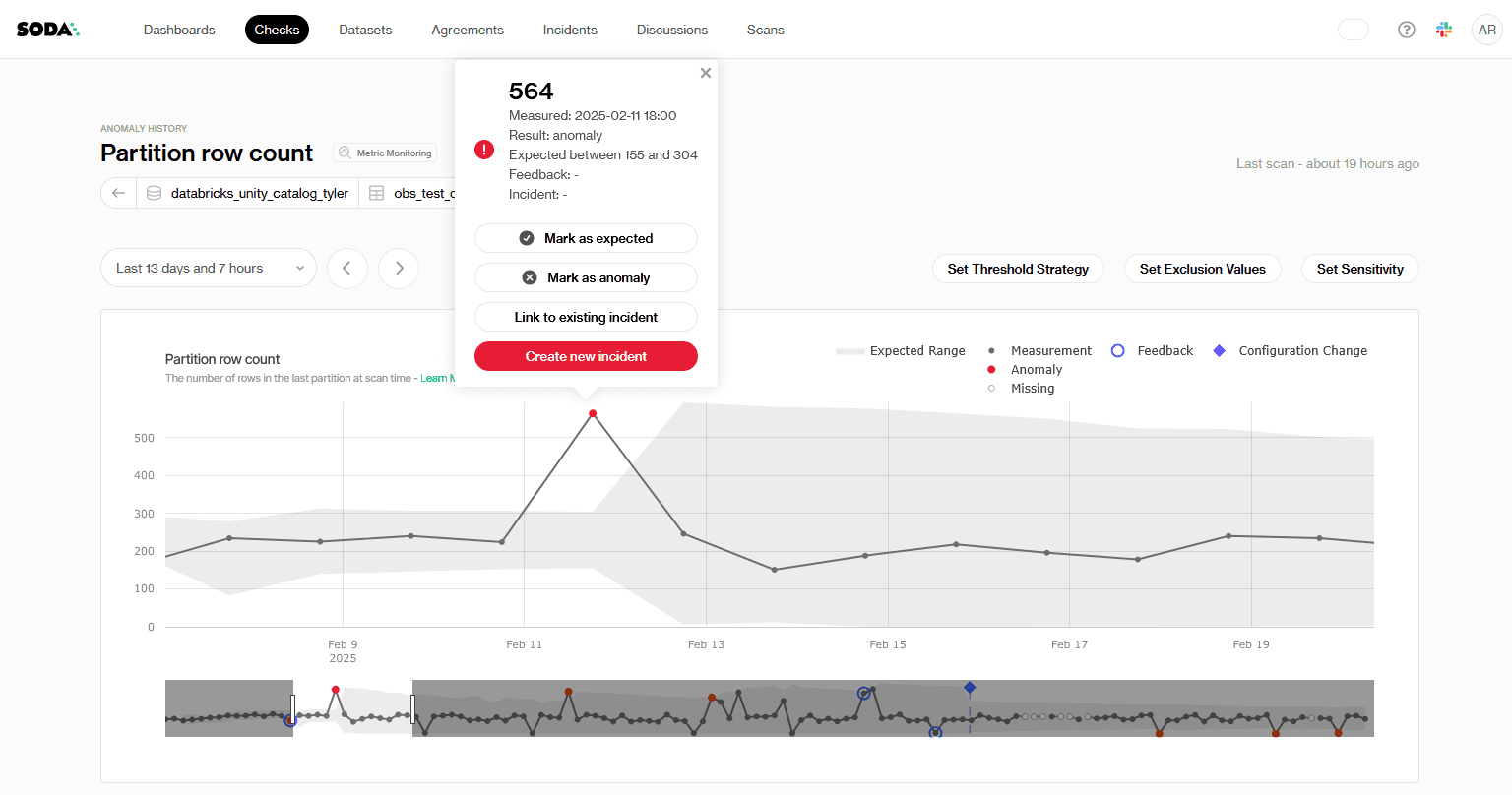

Au lieu de traiter la qualité des données comme une activité post-traitement, les organisations intègrent directement l'observabilité des données dans leurs pipelines. La fraîcheur, le volume, la distribution et le comportement du schéma sont continuellement surveillés, avec des métriques de qualité claires liées aux objectifs de niveau de service.

Plutôt que de se fier uniquement à des seuils prédéfinis, les systèmes de gestion des données de pointe apprennent ce que signifie "normal" au travers des ensembles de données, détectent automatiquement les anomalies et s'adaptent à mesure que les données évoluent. Lorsqu'un élément s'écarte de la norme, des anomalies émergent rapidement, souvent avant que les tableaux de bord, les modèles ou les applications en aval ne soient impactés.

Dans des configurations plus mûres, les agents autonomes vont encore plus loin en corrélant les signaux à travers les pipelines, en prédisant les échecs potentiels et en déclenchant des flux de travail de remédiation avec une intervention humaine minimale. Cela réduit le travail opérationnel qui a traditionnellement consumé les équipes de données, les libérant pour se concentrer sur l'architecture, l'habilitation et la stratégie.

À mesure que la surveillance devient plus automatisée, le prochain défi est de rendre les signaux de qualité compréhensibles et exploitables au-delà de l'équipe de données.

Tendance 3 - Plateformes Pilotées par le Traitement du Langage Naturel

Avec une automatisation plus profonde, 2026 marque également un tournant où le travail sur la qualité des données n'est plus du seul domaine des équipes techniques. Plutôt que de s'attendre à ce que seuls les ingénieurs ou analystes de données écrivent des tests, interprètent des erreurs, et surveillent les pipelines, une nouvelle couche d'interaction assistée par AI rend la gestion de la qualité des données beaucoup plus accessible aux parties prenantes commerciales et aux utilisateurs non techniques.

Les interfaces en langage naturel permettent aux utilisateurs non techniques d'interagir avec la qualité des données en termes simples. Au lieu de chercher à travers des métriques ou écrire du code, les équipes pourront poser des questions simples sur la santé des pipelines, les anomalies récentes, ou les changements dans le comportement des données, puis obtenir des réponses contextuelles.

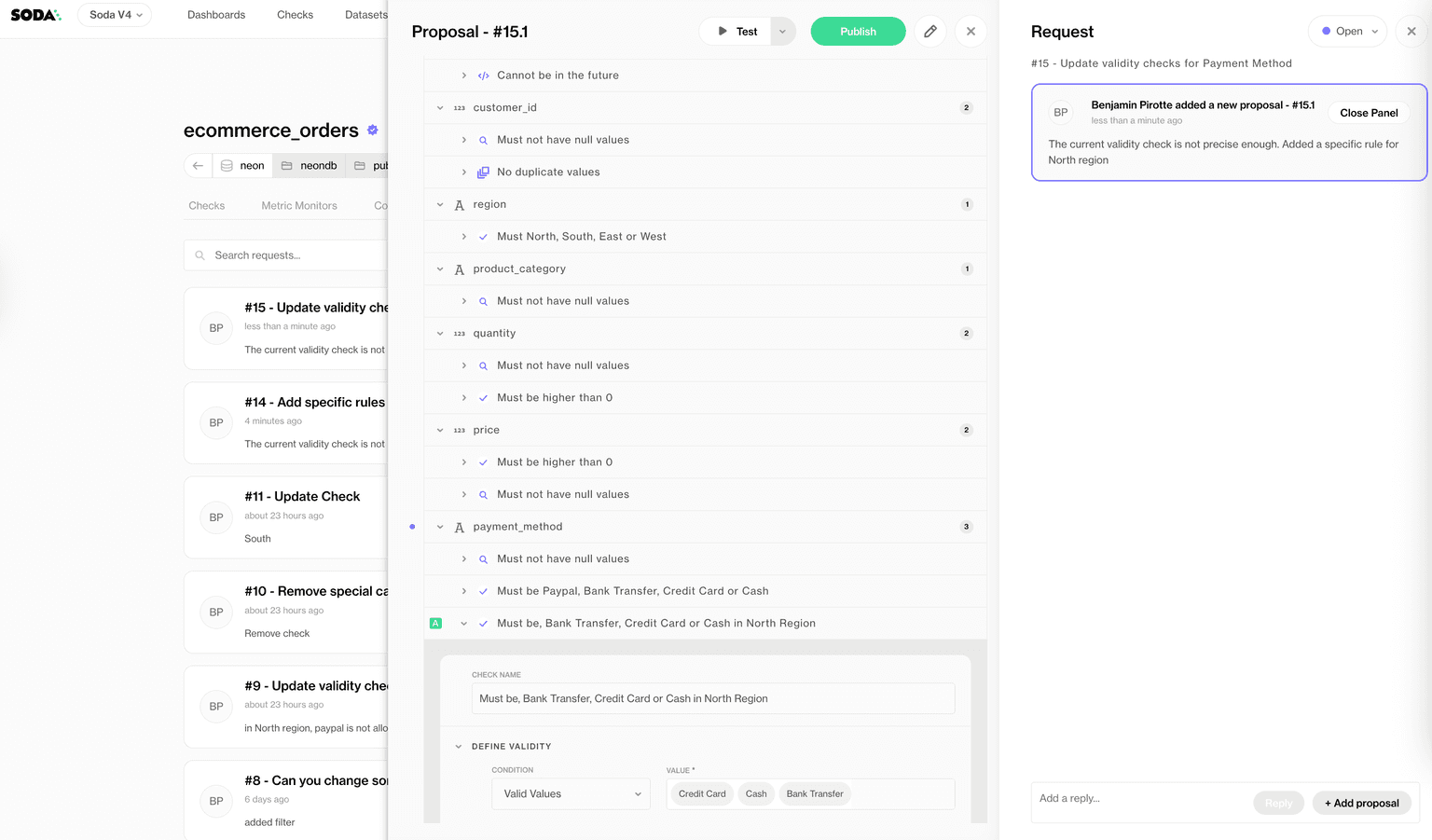

Ces interfaces sont de plus en plus couplées avec des assistants AI qui aident à rédiger, expliquer ou affiner les vérifications de qualité à l'aide du langage naturel. Un utilisateur peut décrire une attente en termes commerciaux, et le système la traduit en une logique exécutable.

En rendant la qualité plus facile à questionner, expliquer et discuter, les plateformes pilotées par le traitement du langage naturel aident les organisations à réagir plus rapidement et rendre la collaboration plus harmonieuse en alignant l'intention commerciale avec la mise en œuvre technique plus tôt dans le processus.

Toutefois, l'expertise humaine restera cruciale. Pour les ingénieurs et analystes de données, cela signifie qu'au lieu d'agir comme des traducteurs entre systèmes et parties prenantes, ils peuvent se concentrer sur la validation de la logique, le raffinement des règles, et l'amélioration de la conception en amont. La gestion de la qualité des données s'appuiera de plus en plus sur l'assistance machine pour étendre la capacité humaine, et non pour la remplacer.

Maintenant que plus de parties prenantes s'impliquent dans la qualité des données, les organisations ont besoin d'accords clairs qui définissent la propriété, les attentes et la responsabilité entre les équipes.

Tendance 4 - Contrats de Données et Gouvernance Adaptative des Données

Une autre tendance claire est que les organisations qui progressent réellement sont celles qui traitent la qualité et la gouvernance des données comme des responsabilités partagées plutôt qu'une fonction informatique. Cela nécessite un changement culturel où les équipes savent ce que "bon" signifie réellement en termes mesurables.

Les équipes ont besoin d'attentes explicites et mesurables pour les données, communiquées de manière cohérente, et appliquées là où les données sont produites ainsi qu'où elles sont consommées.

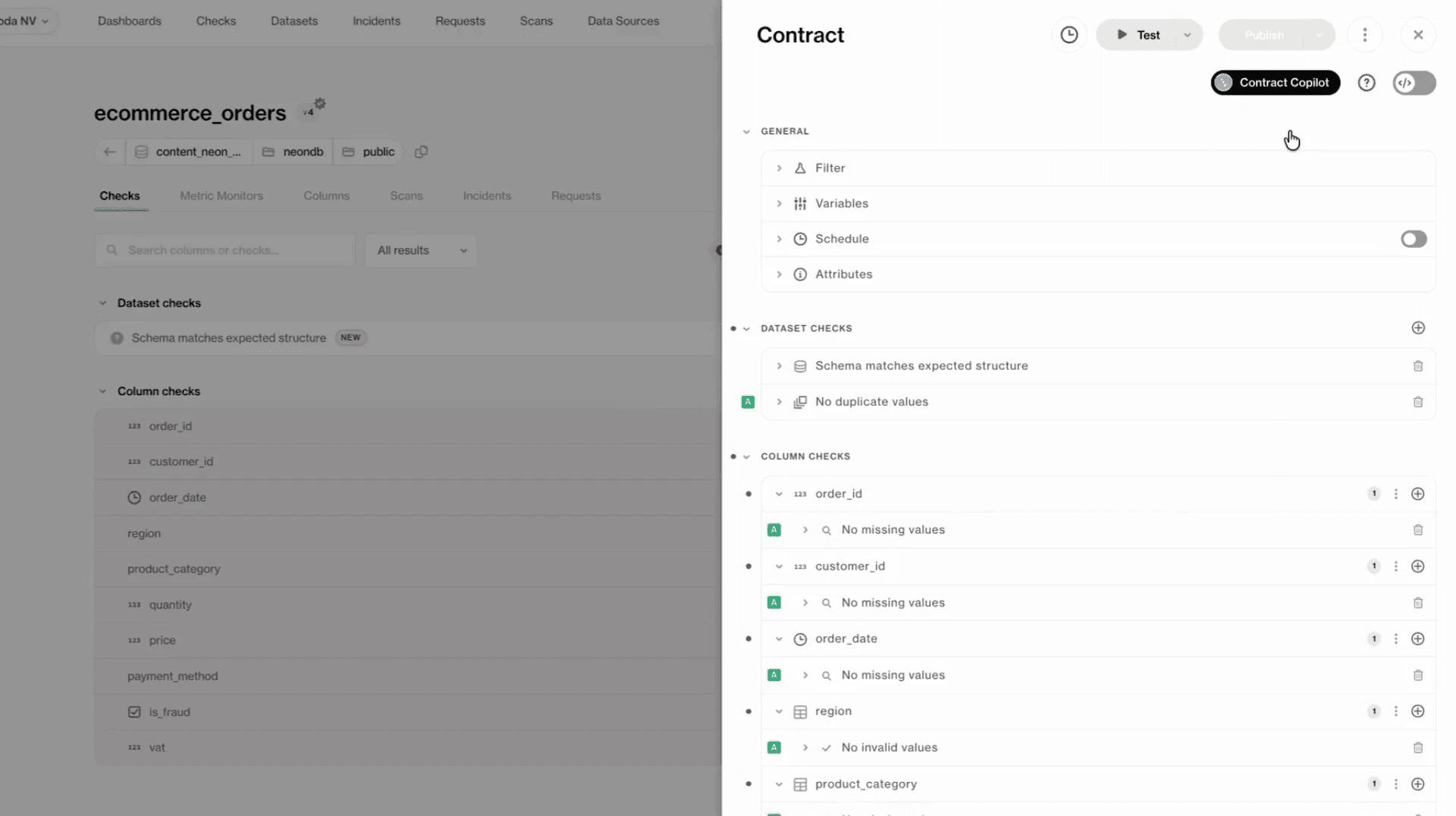

Les contrats de données émergent comme un mécanisme pratique pour soutenir ce changement. À leur base, les contrats de données définissent des accords clairs entre producteurs et consommateurs de données, tels que le schéma, les attentes de qualité, les règles de validation et la propriété.

En rendant ces attentes explicites et exécutables, les contrats réduisent l'ambiguïté et aident à prévenir les surprises en aval.

La gouvernance adaptative des données se construit sur cette base. Plutôt que des règles statiques et descendantes, la gouvernance évolue parallèlement à l'utilisation des données, au risque et aux exigences réglementaires. À mesure que les systèmes AI deviennent plus répandus, la gouvernance doit également soutenir la transparence, la traçabilité et l'utilisation responsable, sans devenir un goulet d'étranglement à l'innovation et à la prise de décision.

Soda Collaborative Data Contracts

Ayant dit cela, définir des attentes n'est efficace que si les organisations peuvent prouver comment les données circulent, changent et sont utilisées à travers les systèmes.

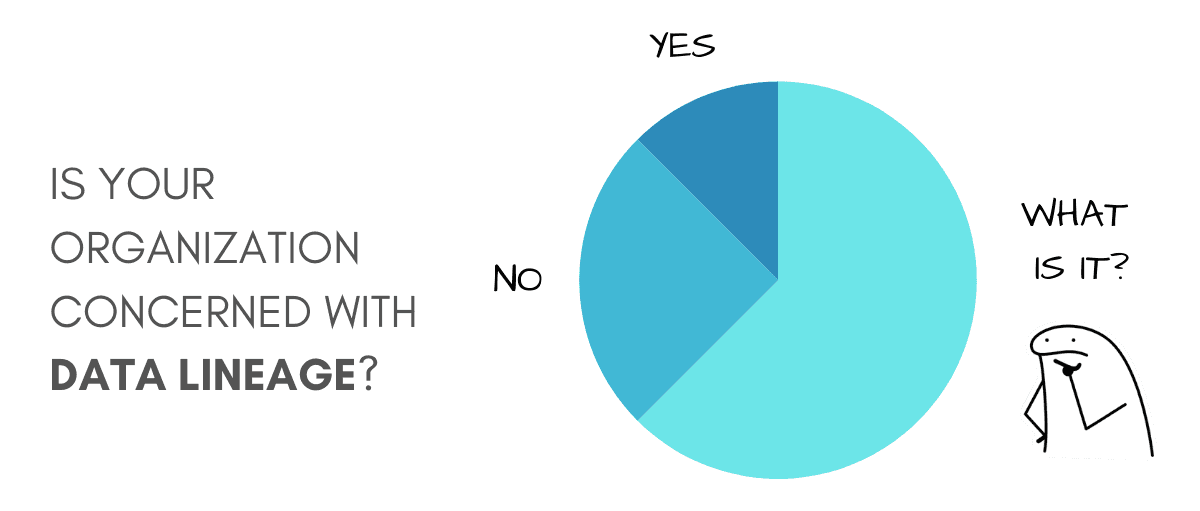

Tendance 5 - Lignée des Données, Transparence & Conformité

En 2026, les organisations continueront d'être sous une pression croissante pour expliquer d'où viennent les données, comment elles sont transformées, et comment elles sont finalement utilisées par les modèles, tableaux de bord, et systèmes automatisés. Sans cette visibilité, la confiance dans les analyses et l'AI s'érode rapidement.

À mesure que les volumes de données augmentent et que les architectures deviennent plus distribuées, la lignée des données offre cette visibilité. Elle permet aux équipes de retracer les données depuis la source jusqu'à la consommation, montrant comment les entrées ont été transformées en cours de route.

Lorsque les résultats semblent erronés ou que les décisions sont remises en question, la lignée permet d'enquêter rapidement, permettant aux équipes d'évaluer l'impact des changements de données avant qu'ils ne se propagent en aval.

La pression réglementaire — telle que la conformité avec le RGPD et la protection des informations sensibles — accélère ce besoin d'une infrastructure de confiance. De nouvelles règles sur l'utilisation des données, la vie privée, et la transparence de l'AI augmentent le coût de ne pas savoir comment les données sont gérées. À mesure que les organisations opèrent à travers les régions, les données doivent se conformer à différentes exigences de stockage, d'accès, et d'utilisation, sous peine de se voir infliger des pénalités financières et une exposition légale. Dans cet environnement, être capable de démontrer la transparence et le contrôle est aussi important que d'obtenir des gains de performance.

Plutôt que de ralentir l'innovation, en investissant dans l'observabilité, le test, les contrats et la lignée, les organisations pourront avancer en sachant qu'elles peuvent soutenir les données sur lesquelles elles s'appuient, expliquer les décisions et étendre l'AI plus confiantes.

Un Guide Pratique pour les CDOs en 2026

Ensemble, ces cinq tendances indiquent un changement significatif dans la manière dont les organisations abordent les données et l'AI en 2026. La question n'est plus de savoir si investir dans l'AI, mais plutôt si les fondations de données sous-jacentes sont suffisamment robustes pour soutenir des résultats commerciaux réels.

Les organisations de classe mondiale ne choisissent pas entre innovation et fondamentaux. Comme la recherche le montre de manière constante, elles investissent dans les deux, mais dans le bon ordre.

Pour les CDOs et les leaders de données, cela se traduit par un ensemble de priorités pratiques :

Implémenter des vérifications automatisées de la qualité des données qui fonctionnent en continu.

Utiliser la détection d'anomalies et des alertes intelligentes pour diriger l'attention vers les problèmes vraiment importants.

Adopter des contrats de données avec des règles de qualité exécutables pour aligner les producteurs et les consommateurs.

Centraliser les résultats de qualité et la lignée, permettant la traçabilité des systèmes sources aux tableaux de bord et modèles.

Surveiller les métriques de qualité opérationnelle comme les SLA de qualité, la fréquence des incidents, et le temps de résolution comme indicateurs de préparation et ROI de l'AI.

En ancrant les initiatives AI dans des pratiques de données fiables, les organisations peuvent avancer plus rapidement avec moins de risque, une responsabilité plus claire, et une plus grande confiance dans les résultats qu'elles livrent.

Voici à 2026 une année de progrès significatif, construite sur des fondations de données solides, conçue pour l'échelle, et prête pour tout ce qui suit.